Vortrag im autopoietischen Kreis 11. 9.2024

|

[ zurück ] [ Stichworte ] [ Die Hyper-Bibliothek ] [ Systemtheorie ] [ Meine Bücher ] [ Meine Blogs ]

|

|

|

Ursprüngliche Ankündigung:

|

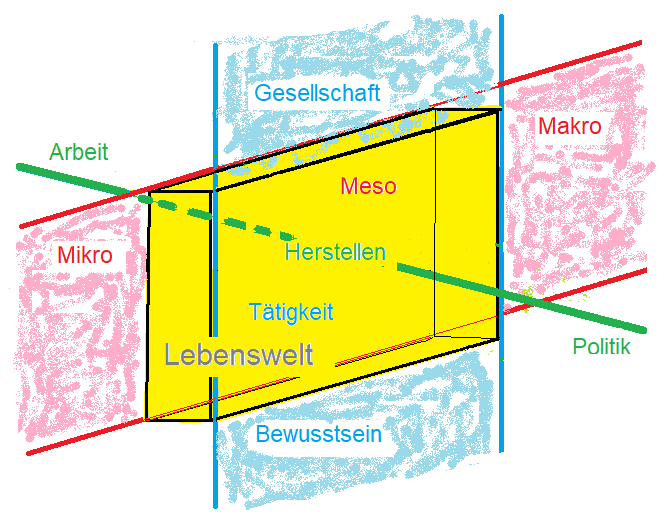

Vor dem Vortrag:Viele von Euch kennen mich und meine Beiträge schon lange. Ich will trotzdem zuerst einige Vorausetzungen, die ich mache, wiederholen, um ein paar naheliegende Missververständisse zu vermeiden. Ich spreche nicht über die Wirklichkeit, ich spreche über mich in meiner Lebenswelt. Ich spreche über Gegenstände, die ich anfassen kann und zwar mit Kategorien des Herstellens. Wissenschaft und Philosophie spielen dabei keine Rolle. Bewusstsein und Gesellschaft kommen in meinen Erwägungen nicht vor, weil ich nicht weiss, was ich mit diesen Wörtern jenseits von Theologie bezeichnen würde. Und Natur verwende ich ausschliesslich als Differenz zur Kultur, zur hergestellten Welt. K. Marx hat vom unorganischen Leib gesprochen: Natur ist das, was in der Autopoiese - die unserem Kreis den Namen gab - aufgehoben wird.

|

|

|

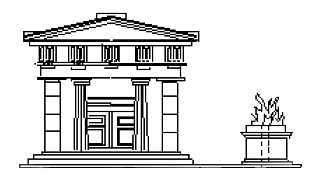

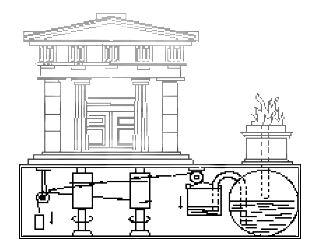

I. Newton sagte: Hypothesis non fingo. Ich mache keine Theorien über die Natur. Ich spreche darüber, was ich beobachte. Ich spreche darüber, was ich mir anhand von Technik wie erkläre. Mein Standardbeispiel ist der Tempel von Heron. Die Türe öffnet sich, wenn der Priester das Tempelfeuer anzündet. Das erkläre ich mir nicht durch Götter oder durch Naturgesetze, sondern durch eine Maschine. Der für mich entscheidende Punkt ist, dass ich die Maschine rekonstruieren, also im Prinzip herstellen kann. Ich erkläre dabei nicht die Maschine, sondern anhand der Maschine, was ich als Phänomen beobachte, nämlich das die Türe aufgeht und ich gerne wüsste, warum. Darin erkenne ich den Wortsinn von konstruktivistischer Erklärung. Heute spreche ich über einen andere Maschine: ChatGPT. Ich betrachte ChatGPT als hergestellte Maschine, die eine Gegenstandsbedeutung oder eine Zweck hat. ChatGPT ist in meiner Beobachtung kein Phänomen, kein Medium, kein Internetbusiness und kein geschaftliches Problem. Ich weiss, dass das viele Menschen ganz anders beobachten. Aber ich will über die Maschine sprechen, auch wenn ich weiss, dass sich viele von Euch mehr für Geist als für Maschinen interessieren. Mein eigentliches Thema ist aber nicht die Maschine, sondern wie wir über Maschinen sprechen. Maschinen sind trivial, wie wir sie beschreiben und begreifen, ist aber oft mit Komplexen verbunden.

|

|

Ich will heute einen Aspekt der Funktionsweise von ChatGPT erläutern und ein paar revolutionäre Thesen über das Sprechen in unseren Dialog bringen. Ich unterscheide zwischen etwas erklären und jemandem etwas erklären. Im Dialog sage ich, was ich mir wie erkläre. Als Erklärung betrachte ich die Beschreibung eines Mechanismus, mit welchem ich das zu klärende Phänomen erzeugen kann. Mit der Maschine von Heron erkläre ich mir, warum sich die Tempeltüren öffnen. Es gibt immer viele Erklärungen, man könnte auch versteckte Sklaven vermuten.

Wenn ich ein Phänomen mit einem Mechanismus erkläre, bestimme ich immer auch genauer, worin ich das Phänomen erkenne. Ich habe Euch vorab gebeten, mit DeepL und ChatGPT etwas zu spielen, damit wir eine gemeinsame Ahnung davon haben, wovon hier die Rede sein soll. Mit DeepL kann ich Texte auf sehr hohem Niveau übersetzen, mit ChatGPT kann ich ganz erstaunliche Texte produzieren. Ich spreche hier hauptsächlich über ChatGPT.

|

Als ChatGPT bezeichne ich einen programmierten Computer, mit welchem ich Texte generieren kann, die ich sogar als Antworten auf von mir gestellten Fragen interpretieren kann. An dieser Stelle muss ich auf meine Sprache aufmerksam machen. Ein Computer ist - in meiner Sprache - eine elektrische Maschine. Ein Computer rechnet nicht. Was hätte der Computer davon, wenn er rechnen würde? Ich verwende manchmal einen Computer beim Rechnen. Und normalerweise weiss ich im Unterschied zum Computer, wozu ich das mache. Ein Computer stellt auch keine Texte her. Ich stelle Texte her und verwende dabei oft einen Computer, auch oft aber einen Bleistift. Im Prinzip - oder umgangssprachlich - könnte ich nach einer Erklärung für die mit ChatGPT produzierten Texte suchen, weil ich diese Texte ganz erstaunlich oder phänomenal finde. In einer Erklärung würde ich aber einen Mechanismus beschreiben, mit welchem ich diese Texte herstellen kann. In diesem Fall habe aber den Mechanismus vor mir. Ich habe die Erklärung schon. |

|

|

Ich kann in einem umgangssprachlichen Sinn sagen, dass ich nicht verstehe, wie dieser Computer funktioniert. Aber ich kann nicht gut annehmen, dass die Funktionsweise nicht verstehbar ist, wenn ich davon ausgehe, dass diese Maschine konstruiert wurde. Mechanismen kann ich nicht erklären, ich verwende sie als Erklärungen. Wenn sie kompliziert sind, kann ich gegenenfalls "jemandem erklären", wie sie funktionieren. Das ist, was ich hier ansatzweise machen will.

Ich spreche hier vom Text herstellen. Ich gehe dabei davon aus, dass der Schrift phylogenetisch gegenüber dem Sprechen das Primat zukommt, dass ich beim Sprechen also entwicklungsgenetisch gesehen Text vertone. Ich habe auch diesen Vortrag zuerst geschrieben. In der ontogenetischen Entwicklung lernte ich das Sprechen vor dem Schreiben. Hier spielt das keine Rolle, weil Sprechen und Schreiben in Bezug auf das Hervorbringen von Äusserungen äquivalent sind. Wir haben Maschinen, mit welchen wir in beide Richtungen hin und her übersetzen können.

Das Sprechen scheint in einer bestimmten Hinsicht komplizierter, weil es keine Wörter zeigt. Ich mache keine erkennbare Zwischenräume zwischen den Wörtern und sage auch keine Satzzeichen. Ich erläutere deshalb das Schreiben, weil es mir anschaulicher scheint und ich das Sprechen ohne weiteres als Ausdruck von implizierten Schriftzeichen begreifen kann.

|

Mit dem ChatGPT stelle ich Texte her. Ich will hier auch davon absehen, ob die Texte am Bildschirm erscheinen oder beispielsweise auf Papier ausgedruckt werden. Die Schriftzeichen sind materielle Gegenstände mit einer je bestimmten Form, beispielsweise geronnene Tinte in der Form eines "a". Text kann ich auch mit einem Bleistift herstellen. Ich kann Schriftzeichen aus Graphit von Hand formen. Dabei verwende ich augenfällig ein anderes Verfahren, als wenn ich mit einem Computer schreibe, auch wenn das Resultat ebenso augenfällig das gleiche ist. In beiden Fällen schreibe ich. Ich verwende nur verschiedene Werkzeuge. In beiden Fällen kann ich mich fragen, wie die jeweiligen Schriftzeichen hergestellt werden. Was Teile meines Körpers machen, wenn ich von Hand schreibe, erkläre ich mir anhand der Operationen, die ich durch die Maschine ausführe, mit der ich Schriftzeichen herstelle. Die Maschine dient mir so als Modell. Sie ist kein Modell von mir, sondern ein Modell, das ein sehr spezifisches Verhalten meines Körpers modelliert, wodurch mein Körper als entsprechende Maschine erscheint, oder eben als etwas, was wie diese Maschine funktioniert. Das bezeichne ich als Kybernetik. |

|

|

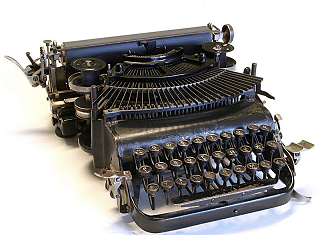

Das Schreibwerkzeug entwickelt sich vom Stab, mit welchem ich im Sand zeichne, zum Bleistift, zur Schreibmaschine bis hin zum Computer. Jede Entwicklungsstufe zeigt, was ich zuvor noch selbst machen musste. Die Schreibmaschine zeigt, dass ich davor die Schriftzeichen selbst formen musste, die elektrische Schreibmaschine zeigt, dass ich dazu - auch wenn ich es kaum gemerkt habe - Kraft brauchte, um die Masse des Bleistiftes zu bewegen.

Ich verwende ChatGPT als Erklärung dafür, wie ich Text generiere. Ich erkläre mir damit anhand eines hergestellten Mechanismus, wie wie ich Text produziere, wenn ich kein ChatGPT habe, sondern beispielsweise mit einem Bleistift schreibe. Dabei gewinne ich zwangsläufig auch eine bestimmte Sicht darauf, was ich beim Scheiben mache und was ich als Schreiben bezeichne.

Wenn ich Text mit einem PC herstelle, passiert oft etwas eigentlich Erstaunliches - auch wenn ich darüber nicht staune. Wenn ich beispielsweise 2 + 3 tippe, erscheint 5, also ein Schriftzeichen, das ich gar nicht getippt habe. Das passiert bei der Schreibmaschine nie. Wenn ich vergessen würde, dass mein Computer eine elektrische Maschine ist, könnte ich sagen, dass er (oder sie) etwas zu meinem Text beiträgt, dass er mitschreibt. Ich könnte die 5 sogar als Antwort auffassen, die er mir auf meine Frage, wieviel zwei und drei ergibt, gibt. Manchmal schlägt mir mein Computer vor, bestimmte Wörter anders zu schreiben. Ich könnte sagen, dass er viel weiss und viel kann oder eben dass er einen Homunkulus enthält, der viel weiss oder intelligent ist. Das macht in meinem Bekanntenkreis aber erstaunlicherweise niemand.

Die Texte, die mit ChatGPT hergestellt werden, scheinen nicht nur mir ausserordentlich erstaunlich. Es sind wohlgeformte Sätze, die sich wie Antworten oder sogar Abhandlungen zu beliebigen Fragen lesen lassen. Ich staune also nicht nur darüber, dass ich mit Computern Schriftzeichen herstellen kann, sondern auch darüber, dass ich Anordnungen von Schriftzeichen herstellen kann, die ich als für mich sinnvolle Sätze lesen kann, ohne dass ich diese Sätze je auf dieser Maschine getippt habe.

Ich kann mich an Eliza erinnern, ein Programm von J. Weizenbaum, das auch erstaunliche Antworten gegeben hat. Aber diese Antworten hat J. Weizenbaum vorab eingegeben. Mit ChatGPT stelle ich Texte her, ich zeige nicht vorabgefertigte Konserven an.

Die Anordnung der Schriftzeichen erfüllt Bedingungen der jeweiligen Schrift. Diese Bedingungen bezeichne ich als Grammatik der jeweiligen Schrift. Ein Text ist ein deutscher Text, wenn er die deutsche Grammatik erfüllt. Als Grammatik bezeichne ich eine systematische Beschreibung der Bedingungen. Anhand der Grammatik beurteile ich, ob ein Text korrekt ist. Die konventionelle Grammatik, die von Subjekt und Objekt handelt, repräsentiert allerdings viel mehr Vorstellungen über den Menschen als über Text.

Wenn ich Text herstelle, kann ich die Grammatik mehr oder weniger berücksichtigen. Mein Text kann unterschiedlich korrekt sein. Sehr viele Texte enthalten Schreib- oder Tippfehler, ohne dass sie deswegen nicht als Texte erkannt würden. Unter bestimmten Umständen bin ich dazu angehalten oder gar gezwungen, mich an die Grammatik zu halten. Insbesondere in der Schule lerne ich grammatikalisch korrekte Texte zu schreiben, wobei unerheblich ist, was im Text zu lesen ist. Ein berühmtes Beispiel für einen Satz, der der Syntax genügt, ist: "farblose grüne Ideen schlafen wütend" und ein etwas weniger berühmter Satz, der das nicht tut ist: "ich essen gerner fleisch braten". Keiner der beiden Sätze genügt einer Grammatik, die Syntax und Semantik umfasst. Im zweiten Satz kann ich jenseits von Grammatik erahnen, worauf er verweisen könnte. Der zweite Satz zeigt, dass ich Text herstellen kann, auch wenn ich sehr wenig grammatikalische Kenntnisse habe und vielleicht gar nicht weiss, dass es Grammatik gibt. Hier geht es nur darum, dass ich ohne weiteres Sätze formulieren kann, die andere verstehen können, ohne mich an die Grammitik zu halten, selbst wenn sie in meinen Genen eingebrannt wäre. Die Grammatik hilft mir beim Schreiben nicht, sie entscheidet nur, ob meine Tetxte grammatikalisch korrekt sind.

Als Textherstellen bezeichne ich - in diesem Kontext - ein Verfahren, das darin besteht, einer bereits vorhandenen Schriftzeichenkette weitere Schriftzeichen anzufügen, so dass ein Text entsteht, den ein Menschen geschrieben haben könnte. Es geht darum, das jeweils nächste Zeichen auszuwählen.

Welches Schriftzeichen jeweils angefügt wird, beruht in diesem Verfahren darauf, welches Schriftzeichen in einer relativ grossen Menge von wohlgeformten Sätzen am meisten auf die bereits vorhandenen Schriftzeichen folgt. Dabei werden ein paar raffinierte Teilverfahren verwendet, die hier keine Rolle spielen. Es geht im Wesentlichen darum, wie die Sätze, die als Vorbilder verwendet werden, so aufbereitet werden, dass sie die Wahl des jeweils nächsten Schriftzeichen ermöglichen.

|

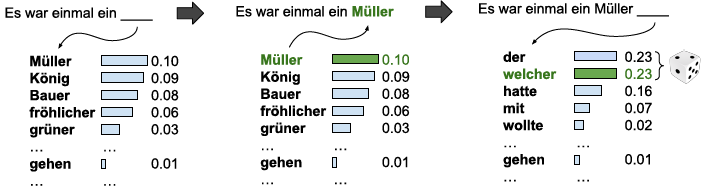

Ich erläutere, wie ich mit ChatGPT das jeweils nächste Schriftzeichen wähle, respektive, wie der Mechanismus dabei funktioniert. Ich beschreibe aber zunächst das Verfahren ohne mich um den Mechanismus und dessen Operationen zu kümmern. Das Verfahren wurde bereits von unzähligen Autoren beschrieben. Über den materiellen Mechanismus dagegen gibt es sehr wenig zu lesen. Das Verfahren wird ausserdem fast immer in einem kognitivistischen Jargon beschrieben, in welchem von neuronalen Netzen gesprochen wird, die - ob Nerven oder Maschinen - etwas tun. Ich beschreibe hier ein Verfahren, das ich anwende, wenn ich ChatGPT verwende. Mit ChatGPT kann ich das Verfahren einfach sehr effizient machen, was ja der Sinn von Werkzeugen ist. Ich kann das Verfahren aber auch jenseits von Computern beschreiben - auch wenn ich es ohne Computer nicht effizient verwenden könnte. Um das Verfahren anschaulicher zu erläutern, verwende ich hier anstelle von Schriftzeichen ganze Wörter, obwohl das Verfahren mit Wörtern viel schlechtere Resultate ergibt, als wenn ich es mit Schriftzeichen anwende. Ich verwende überdies eine sehr kleine Menge von Texten als Vorgabe. Das Beispiel, das ich hier verwende, stammt von M. Hielscher und ist unter www.soekia.ch zu finden. Ich verwende vier Märchen von Grimm und beginne meinen Text mit "Es war einmal ein". Dann kann ich - aufgrund der Vorlagen - unter ein paar anderen Wörtern "König", "Müller", "grüner" einsetzen, wodurch sich mein Satz verlängert und das Spiel von neuem beginnt. Wenn ich Müller eingesetzt habe, kommen als nächstes Wort "der" und "welcher" in Frage, die überdies hinter einem Komma stehen. Die einzelnen Wörter haben eine Gewichtung, je nachdem, wie oft sie in den Vorlagen vorgekommen sind. Im Beispiel wird "Müller" gewählt. Bei der zweiten Wahl haben "der" und "welcher" das gleiche Gewicht, ich verwende für die Wahl einen Würfel. |

|

|

Bildquelle: www.soekia.ch

|

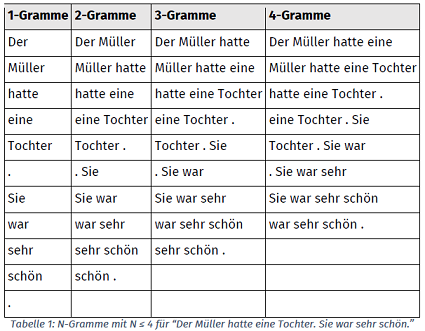

Die Gewichte der einzelnen Wörter schreibe ich in eine Tabelle, damit ich sie sofort finden kann. Diese Tabelle bezeichne ich als N-Gramm. Dieses Wort stammt wohl von Googles Ngram-Viewer. Ich unterscheide verschiedene N-Gramme, die verschieden lange Sequenzen enthalten. Die Sequenzen aus einem 4-Gramm kommen in einem Textkorpus logischerweise viel weniger oft vor als jene aus einen 1-Gramm. Deshalb wähle ich für meinen Text jeweils das N-Gramm mit der höchsten Zahl, in welchem ich meine Textsequenz finden kann. Das Verfahren kann erheblich komplizierter gemacht werden. Darauf will ich hier nicht eingehen. Ich will nur hervorheben, dass die N-Gramme keine Wörter enthalten müssen. Sie enthalten Schriftzeichenketten, die ich Token nenne. Ich zerlege beispielsweise die Textkette "wasisteingutersatz" in die Token "wasi stei gute rsat z.", die ich dann anstelle von Wörtern verwende. Wenn ich das Verfahren von Hand anwende, ist es mit Wörtern für mich viel übersichtlicher, wenn ich aber einen Computer verwende, spielt es natürlich keine Rolle, ob die Token Wörter sind. Dass dieses Verfahren funktioniert, ist erstaunlich und nicht erklärbar. Es wurde wie beliebige andere Verfahren von Menschen gefunden und entwickelt. Jemand ist - wie und warum auch immer - auf die Idee gekommen, dem Brotteig Hefe beizugeben. Jemand hat gemerkt, dass man mit einem sich drehenden Magneten elektrischen Strom erzeugen kann. Und jemand hat gemerkt, dass man Texte hervorbringen kann, indem man dieses Verfahren verwendet. Nachdem das Verfahren entdeckt ist, kann jeder prüfen, ob und wie gut es funktioniert. Wenn ich das Verfahren auf dieser einfachen Stufe überprüfe, staune ich darüber, dass es überhaupt funktioniert. Ich sehe aber natürlich auch, dass das Verfahren etwas ausgebaut werden muss, ohne dass ich hier sagen könnte wie. Da es aber ChatGPT gibt, ist auch klar, dass das Verfahren nicht nur im Prinzip funktioniert. Und wer schon andere Texte über ChatGPT gelesen hat, mag darüber staunen, wie einfach dieses Verfahren im Prinzip ist. |

|

Bildquelle: www.soekia.ch |

Es geht hier aber nicht darum, die Funktionsweise von ChatGPT insgesamt zu erklären, sondern darum, ChatGPT als Modell für Textgenerierung zu erläutern, weil ich ChatGPT als Erklärung dafür verwenden will, was ich beim Schreiben - gemäss diesem Modell - mache. Deshalb will ich jetzt das Verfahren noch unter einem anderen Gesichtspunkt erläutern, der unwichtig scheint, aber für die Entwicklung der Maschine eine entscheidende Erfindung darstellt.

Das Generieren von Text - das ich jetzt anhand der Entwicklung eines Textes durch Anfügen von ausgewählten Schriftzeichen erläutert habe - ist als Verfahren in ChatGPT aufgehoben. Das beschriebene Abarbeiten von N-Gramms würde aber eine ungeheure Rechenleistung und Speicherkapazität voraussetzen. Es funktioniert nur mit einer speziellen Technik, die umgangssprachlich als neuronales Netzwerk bezeichnet wird.

|

Die Bilderkennung, die komischerweise sehr oft als Mustererkennung bezeichnet wird, obwohl Bilder und Muster ziemlich verschiedenen Sachen sind. Die sogenannte Text- oder Datenverarbeitung, die lange Zeit im Zentrum der Verwendung von Computern standen, beruhen auf einer seriellen Abarbeitung, in welcher die Zeichen wie in einem Text nacheinander in einer Reihenfolge stehen. In der Bilderkennung, deren Auslöser wohl die sogenannt digitalen Kameras gewesen sind, geht es um Pixelmengen, die mit der konventionellen Technik nicht immer weniger gut vereinbar waren. Man realisierte, dass Menschen auch mit solchen "Daten", die eben keine waren, umgehen muss und erinnerte sich an die neuronalen Netze, die sich auch ohne Markt weiterentwickelt haben. Ich will hier nicht näher darauf eingehen, was neuronale Netzwerke sind, sondern nur einen Apekt hervorheben, bei welchem es darum geht, dass Verteilungen in Rastern, die eben Bilder ausmachen, wiedererkannt werden und mit anderen Verteilungen verknüpft werden können. Ein typisches Beispiel - das als DeepMind auch Geschichte geschrieben hat -, besteht in einer bestimmten Konstellation von Figuren auf einem Schachbrett, wobei der nächste Zug zu wählen ist. Man vergleicht mögliche Folgekobstellationen, die in einer Bibliothekt festgehalten sind, und wählt dann jene Konstellation, die zu einem Gewinn geführt hat. Man rechnet also nicht durch, was die Folgen eines bestimmten Zuges sein können, sondern kopiert einen Verlauf, der - eben mehr als einmal - erfolgreich war. Es geht also wie bei der Wahl des jeweils nächsten Schriftzeichens um die Wahl des nächsten Zuges, für welchen keine logischen Berechnungen gemacht werden, sondern in einem N-Gramm geschaut wird, was sich schon einmal bewährt hat. Diese Technik hat eine lange Tradition. Als während des sogenannten 2. Weltkrieges die ersten Computer konstruiert wurden, gab es zwei sehr verschiedene Ansätze, wobei sich der an programmierbaren Automaten, wie sie J. von Neumann beschrieben hat, also an Maschinen, die in der Natur kein Vorbild haben, absolut durchgesetzt hat. Schon 1956 wurden aber neuronale Ansätze in einer grossen Konference in Dartmouth, in welcher von intelligenten und lernenden System gesprochen wurde, diskutiert. D. Hebb hatte mit seinen behavioistischen Verstärkungsregeln dazu einen Grundstein gelegt. |

|

|

In den 1970er Jahren traten bestimmte Beschränktungen der Von-Neumann-Architektur in Bezug auf Bildbearbeitung immer deutlicher zu tage. T. Kohonen und etwas später J. Hopfield, der 1985 eine Lösung des Travelling Salesman veröffentlichte, lancierten neuronales Lernen neu. Die schon länger bekannte Backpropagation of Error als Verallgemeinerung der Delta-Regel machten nicht linear separierbare Probleme durch mehrschichtige Perceptrons lösbar. Entscheidend sind aber die Verstärkungen geblieben, durch die viele nicht gebrauchten Daten oder Operationen ausgeschlossen werden können. Beim Schach etwa kann auf viele Berechnungen verzichtet werden.

2017 zeichnete sich ein Durchbruch dieser Technik in Bezug auf Textproduktion ab, die - wieder lustigerweise - als DeepLearning bezeichnet wurde, obwohl oder weil es mit Lernen im umgangssprachlichen Sinn nichts zu tun hat, aber natürlich das behavioristische "Lernen" bezeichnet.

Ich will es mit der Erläuterung der Maschine dabei belassen und mich jetzt der Frage zuwenden, was diese Maschine über die Textherstellung von Menschen sagt. Dazu beschreibe ich das Verhalten eines Kleinkindes mit den Kategorien, die ich anhand von ChatGPT gewonnen habe. Ich meine nicht, dass ein Kleinkind ein Maschine sei oder wie eine Maschine funktioniere. Es geht hier also nicht um Kinder, sondern um Textproduktion in einer definierten Perspektive.

Ich beobachte Verhaltensweisen, die behavioristisch verstärkt werden, also mit der Zeit regelmässiger vorkommen, als andere Verhaltensweisen.

Ein Kind spricht nicht, wenn es auf die Welt kommt. Normalerweise macht es allerlei Bewegungen und Geräusche. Unter guten Bedingungen wird es von seiner Mutter gestillt. Das Kind kann das nicht beeinflussen, aber es kann trinken, wenn es an die Brust genommen wird. Ich erkenne darin eine Verhaltensweise, die ich einem Reflex zurechne. Ich nehme nicht an, dass das Kind weiss, dass es trinken muss oder wozu es gut sein könnte, zu trinken. Ich kann beobachten, dass ein Kind macht, was es macht, wenn es die Möglichkeiten dazu bekommt. Hypothesis non fingo.

Ich weiss nicht, warum ein Kleinkind schreit. Ich nehme nicht an, dass es damit ein Ziel verfolgt. Ich würde auch nicht sagen, dass es schreien gelernt hat. Natürlich könnte ich darüber staunen, dass es schreit, und nach Erklärungen suchen. Instinkt und Reflexe fungieren als Erklärungen, aber genauer besehen, sind das Erklärungsprinzipien, für etwas, was ich nicht erklären kann. Ein ebenfalls wichtiges Erklärungsprinzip ist das Nachahmen. Aber wieso sollte ein Kind etwas nachahmen? Und normalerweise schreien die Eltern des Kindes ja nicht.

Behavioristische Verhaltensforscher gehen davon aus, dass das Schreien zunächst zufällig oder angeboren ist und mit der Zeit durch Reaktionen der Umwelt situativ verstärkt wird. Ich nehme an, dass das für jedes Verhalten eines Kleinkindes unterstellt werden kann. Insbesondere eben auch bei Verlautbarungen, die kein Schreien, sondern etwa ein Plappern sind. Dazu muss ein Kind Unterschiede in seinem eigenen Verhalten wahrnehmen und mit Reaktionen der Umwelt verbinden können. Es kann merken, dass Schreien zum Stillen führt, obwohl es zuvor nicht dazu geschrienen hat. Das bezeichne ich als behavioristisches Lernen.

An dieser Stelle interessiert, dass ChatGPT bestimmte Formulierungen zunehmend häufiger produziert, ohne dass damit ein Verstehen verbunden wäre. Ich nehme deshalb an, dass das auch bei einem Kleinkind der Fall ist. Bestimmte Formulierungen werden verstärkt, unabhängig davon, was sie bedeuten und unabhängig davon, ob sie zu irgendeiner Grammatik passen.

Das Kind lernt mit der Zeit, welche Formulierungen - die es "neuronal" so zufällig wie ChatGPT verwendet - welche Konsequenzen haben. Auf diese Weise ergibt sich im Nachhinein eine Bedeutung zu den gemachten Formulierungen, die ihren Sinn aber jenseits von Bedeutungen haben. Es sind zufällige Verhaltensweisen, die sich irgendwie bewähren.

Wenn ich auf beispielsweise auf die Frage, weshalb ein Kleinkind schreie, genau denselben Text produziere wie ChatGPT, weshalb sollte ich das dann verschieden erklären?

Ich will dazu noch auf die Experimente von B. Libet verweisen, der gezeigt hat, dass viele Verhaltensweisen von Menschen im neuronalen System einer bewussten Entscheidung dazu vorausgehen. Ein Mensch formuliert in diesem Sinne, was in einer gegebenen Situation aufgrund von Verteilungen zu formulieren ist und erkennt dann, was er gesagt hat oder sagen wollte. Die Experimente von B. Libet wurden später so relativiert, dass dem Erkennen der Bedeutung eine Kontrolle zukommt. Wenn ich erkenne, was ich sage, kann ich es verhindern oder korrigieren. Das ist aber nicht der Punkt, auf den es hier ankommt: ChatGPT hat und braucht diese Möglichkeit nicht.

Hier geht es nicht um Willensfreiheit und andere philosophischen Erwägungen, sondern darum, wie Formulierungen generiert werden. Ein wichtiger Punkt besteht darin, dass ich beim Sprechen keiner Grammatik folge, wie sie inbesondere von N. Chomsky als universell angeboren postuliert wurde. Richtige Sätze beruhen auf einem Mechanismus, der laufend nachgeführt wird. Die Frage, die sich hier stellt, ist vielmehr, wie die jeweilige Formulierung und das, was ich sagen möchte, zusammenhängen.

Verworfen wird in dieser Modellierung, dass ein Sprecher seine Sätze aufgrund von inhaltlichen Überlegungen oder aufgrund von Wortbedeutungen formuliert.

Ich will dazu auf einen weiteren Punkt verweisen. Es gibt ein Verfahren, das Brainstorming genannt wird. Dabei geht es darum, sich nicht zu überlegen, was richtige oder gute Formulierungen wären, sondern spontan zu sagen, as einem gerade in den Sinn kommt. Erst im Nachhinein wird dann geschaut, was davon brauchbar ist. Auch dieses Verfahren beruht auf einer Entkoppelung der Formulierungen und sinnvoll Gemeintem.

Ich will nun die ganze Sache in gewisser Weise auf die Füsse stellen, indem ich das Sprechen als Tätigkeit beobachte. Keine Maschine spricht, was hätte sie davon?

ChatGPT stellt keine Texte her. Das zeigt sich insbesondere darin, dass ChatGPT nie anfängt, also nie das erste Zeichen eines Textes produziert. ChatGPT muss wie jede Maschine angestellt werden. Ich muss ChatGPT ein paar Schriftzeichen vorgeben.

Man hat gesagt, dass es keine Problem wäre, ChatGPT so zu programmieren, dass es hin und wieder "etwas sage". Roboter und andere embodied systems würden ja auch ... Das halte ich für ein Missverständnis. Ich kenne keinen Roboter - ausser natürlich jene von I.Asimov -, die sich gelegentlich überlegen, was sie tun könnten.

Jetzt muss ich mich fragen, weshalb ich Text herstelle. Ich gehe davon aus, dass wann immer ich es tue, meine Formulierungen wie jene von ChatGPT entstehen. Die Frage ist also, weshalb stelle ich dann und wann erste Schriftzeichen her, die mir quasi unter der Hand zu sinnvollen Sätzen werden.

Ich betrachte das Schreiben als herstellende Tätigkeit und jede herstellende Tätigkeit als Aneignung. Das Herstellen ist die Praxis der menschlichen Autopiese. Menschen sind Menschen, weil sie herstellen. Menschen stellen nicht nur her, sie konsumieren auch. Sie arbeiten wie Tiere. Dass ich das Herstellen beobachte, ist eine bewusste Wahl, die sich hier beim Schreiben - viel mehr als beim Sprechen - bewährt. Als Herstellen bezeichne ich das Formen von Gegenständen, hier insbesondere das Formen von Schrift zeichen und Anordnen dieser Schriftzeichen.

Das Schreiben wird in der herrschenden Kultur vom Herstellen entkoppelt, es scheint etwas anderes zu sein, weil jene die schreiben selten arbeiten. Schreiben wird einer Kommunikation zugerechnet, in welcher die Herrschenden diktieren, was andere tun. Ich habe diese Sichtweise in meinem Buch "Technische Intelligenz" ausführlich behandelt.

Das Schreiben hat seinen Ursprung nicht in einer Kommunikation, sondern im praktischen Anliegen des externen Gedächtnisses. Die ersten Menschen haben für sich geschrieben. Erst die Herrschaft hat das Schreiben zum Mittel der Unterdrückung gemacht. ChatGPT zeigt, Schreiben in seinem ursprünglichen Sinn, viele Menschen haben Angst davor. Ich hoffe, Sie gehören nicht dazu. Ich danke für Ihre Aufmerksamkeit.